¿Cómo se pueden abordar los desafíos de suministro de energía de IA/HPC?

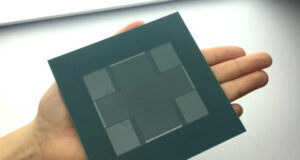

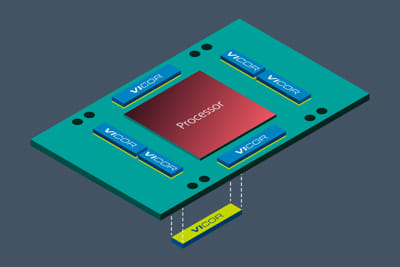

Un enfoque importante para reducir el consumo de energía genAI y, al mismo tiempo, mejorar la calidad de la entrega de energía, se relaciona con la ubicación física de los componentes de energía del punto de carga. Al mover estos componentes de energía de la etapa final de una ubicación lateral a una ubicación vertical directamente debajo del procesador genAI, se reduce la cantidad de energía disipada en la propia placa de circuito impreso. Con una densidad de corriente de alrededor de 3 A/mm2, el multiplicador de corriente del punto de carga puede compartir el espacio muy limitado debajo del procesador de entrenamiento genAI.

Esta reducción de la potencia térmica de la PCB es posible porque la impedancia concentrada de la red de suministro de energía colocada verticalmente se reduce hasta en un factor de 20 en comparación con la colocación de un componente de energía lateral puro. Además, la calidad de la entrega de energía aumenta, porque la entrega de energía vertical (VPD) también permite una distribución uniforme y estrictamente regulada del voltaje de suministro (VDD) a través de la superficie de la matriz de silicio del procesador.

En una arquitectura VPD, es posible que se eliminen 50 mV de variación del voltaje de suministro en comparación con una solución tradicional de punto de carga colocada lateralmente. Cuando se multiplica por 1.000 o más amperios, esto produce otros 50 W o más de ahorro potencial de energía.

En una escala más macro, ¿cuánta energía se puede ahorrar cuando se implementa VPD utilizando módulos de potencia de alta densidad en los centros de datos genAI/HPC?

En la actualidad, las supercomputadoras de entrenamiento genAI más grandes implementan hasta 20.000 módulos aceleradores. Sorprendentemente, según Nvidia, el GPT-3 de OpenAI con 175 mil millones de parámetros requiere alrededor de 300 zettaFLOPS (1.021 operaciones de punto flotante por segundo), lo que equivale a 300 billones de billones de operaciones matemáticas en todo el ciclo de entrenamiento del modelo. Estos tamaños de modelos solo van a aumentar, con modelos de redes neuronales de billones de parámetros en desarrollo en la actualidad.

Vicor estima que el VPD factorizado puede ahorrar alrededor de 100 vatios por módulo acelerador en comparación con la entrega de potencia lateral TLVR tradicional. Tenga en cuenta que las supercomputadoras de IA se activan esencialmente a perpetuidad (nunca se apagan).

Haciendo suposiciones razonables sobre la cantidad de centros de datos genAI en funcionamiento a nivel mundial para 2027, Vicor estima un ahorro agregado de Teravatios de energía, equivalente a miles de millones de dólares en costos de energía eléctrica y millones de toneladas de reducciones de dióxido de carbono anualmente (dependiendo de la mezcla de energía renovable) y a perpetuidad.